چرا هوش مصنوعی در «غار افلاطون» زندانی است؟

آره

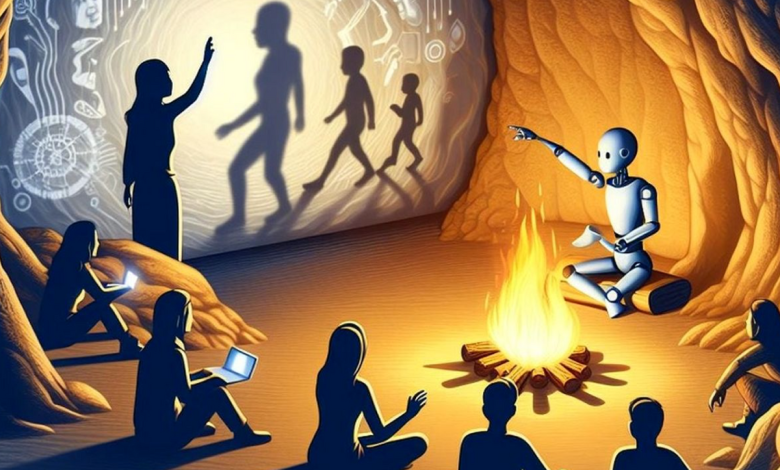

این افلاطون بود که این ایده را برای اولین بار مطرح کرد. او در تمثیل معروف «غار» زندانیان را به زنجیر بسته در غار به تصویر می کشد که صورتشان به دیوار است در حالی که آتشی پشت سرشان می سوزد. زندانیان نمی توانستند چیزی جز سایه هایی که روی دیوار جلوی آنها افکنده بود درک کنند. آنها خودشان نمی توانستند چیزها را ببینند و همه چیزهایی را که از جلوی آتش می گذشت فقط با سایه آن روی دیوار می دانستند. به نظر می رسد که این مثل هنوز در زمان ما قابل اجرا است و می تواند محدودیت های درک ما را توضیح دهد.

به گزارش فرادید؛ در زمینه مدرن، میتوانیم محدودیتهای مدلهای هوش مصنوعی را مشابه محدودیتهای زندانیان افلاطون تصور کنیم. هوش مصنوعی ربطی به خود دنیا و چیزهای موجود در آن ندارد، فقط به داده هایی که ما به آن می دهیم نگاه می کند. سعی میکند این سایهها را معنا کند و همزمان احتمالات، روابط، الگوها یا روندها را ارزیابی میکند تا بهترین پیشبینیهای موجود را انجام دهد. اساساً هوش مصنوعی در غار داده خودش قفل شده است.

ده ها اساساً تفسیری از جهان ما و بخش های مختلف آن هستند. آنها صرفاً ارائه ای انتخابی از مشاهدات، اندازه گیری ها و اطلاعات در مورد پدیده های مختلف هستند. از آنجایی که خود داده ها نامحدود هستند، فرآیند انتخاب داده ها محدود می شود و بنابراین ذاتاً پالایش شده و شخصی می شود.

مدلهای هوش مصنوعی که ما بر روی این دادهها ایجاد میکنیم بر اساس سادهسازیها هستند تا در عین حال که برای ما منطقی باشند مقرون به صرفهتر باشند. در نتیجه هیچ مدلی از هوش مصنوعی نمی تواند بازتابی کامل و جامع از دنیای واقعی باشد، بلکه تنها نسخه ای ساده و جزئی از آن است.

دادههایی که برای آموزش مدلها نیاز داریم نیز میتوانند ناقص، اریب یا مغرضانه باشند. وقتی این اتفاق می افتد، مدل ها چیزی را تولید می کنند که مردم آن را بی معنی تفسیر می کنند. خود مدل ها نمی توانند اشتباهات خود را از چشم انسان ببینند زیرا آنها فقط آنچه را که به آنها تغذیه می شود می بینند. همانطور که سایه های افلاطون دید زندانیان را محدود می کند، ما جهان را برای مدل های هوش مصنوعی خود محدود می کنیم.

به همین دلیل است که مدلهای هوش مصنوعی مرتکب اشتباهاتی میشوند مانند: پیشبینی اتوبوسی که با دو سال تاخیر میرسد، تشخیص کیف پولی که در واقع یک آجر است، یا ایجاد تصویری از یک گربه با پنج پا! در دنیای مدلینگ، همه اینها نتایج معتبری هستند. اما در دنیای ما، اینها پیش بینی های بد، تشخیص های اشتباه یا توهم هستند.

اما اگر مدلهای هوش مصنوعی کشف کنند که میتوان مستقل از مشاهدات، تفاسیر و محدودیتهای ما، درباره جهان یاد گرفت، ممکن است استراتژیها و دیدگاههای منحصربهفرد خود را از جهان توسعه دهند.

در یک بازی که در آن یک شطرنج باز مدل به نام “آلفاگو” در برابر قهرمان انسانی به نام لی سدول بازی کرد، آلفاگو حرکتی را انجام داد که کارشناسان در ابتدا آن را “احمقانه” نامیدند اما در نهایت “احمق” شد. چنین موردی نشان می دهد که مدل های هوش مصنوعی خودآموز می توانند راه حل ها و پدیده هایی را ببینند که انسان ها نمی توانند ببینند.

افلاطون در تمثیل غار می گوید وظیفه فیلسوف این است که با خروج از غار و نگاه به عقاید، کلیات، الگوها و مفاهیم مختلف، جهان را بیشتر بشناسد. با بالا رفتن از سایه ها به کلیات و انتزاعات، ما شروع به درک جهان می کنیم و از درک فقط قلمرو مرئی به مفهوم سازی در قلمرو اندیشه و هوش حرکت می کنیم.

اما برای اینکه هوش مصنوعی فعلی از غار خارج شود و هوش خود را توسعه دهد، به زمان و منابع نیاز دارد. در این میان، باید به خاطر داشته باشیم که سیستمهای هوش مصنوعی ما عمدتاً مدلهای تخصصی هستند که ما آموزش میدهیم و تغذیه میکنیم.

این مدل ها در درک خود محدود هستند. ما در مرحله ای هستیم که هوش مصنوعی می تواند الگوها را تشخیص دهد و پیش بینی کند، اما نمی تواند افکار شناختی یا انتزاعی ایجاد کند. همچنین لازم نیست افلاطونی گرا باشیم تا به یاد داشته باشیم که هر چقدر هم که نتایج هوش مصنوعی جذاب باشد، باید تفکر انتقادی خود را حفظ کنیم و همیشه به خاطر داشته باشیم که هوش مصنوعی همچنان در یک غار گیر کرده است.